【技术向】什么是端到端自动驾驶 - part3

特斯拉已经在员工内部开始推送端到端自动驾驶V12版本(感知决策一体化由神经网络完成),但是目前反响似乎一般。

不过这种进度其实超出了很多团队的预料,在2023年初的时候很多团队预计是在2024年底才会有真正可以小范围推广的版本。

这件事为什么这么难?

⚡因为之前分模块的方案配套的测试和改进手段都失效了,而且一切都交给神经网络的方式,需要更常强大的数据处理和搜集能力才行。

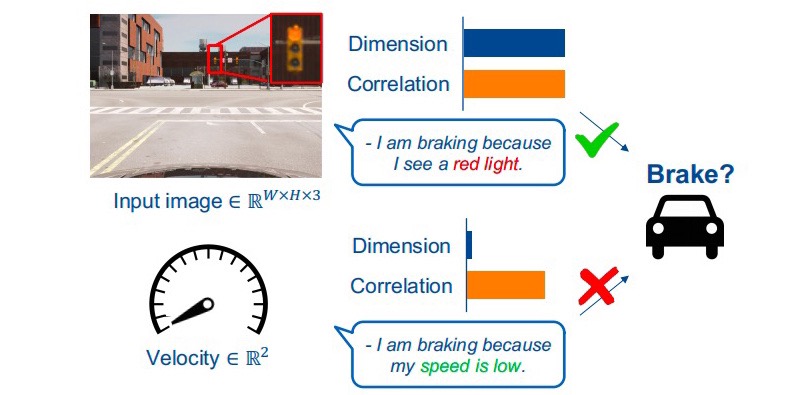

一个很典型的例子是: 一辆车在红绿灯面前停住了。

神经网络学习到的规律可能是:

-

看到了红灯需要停住(正确)

-

车速变慢了需要停住(错误)

这是因果混淆造成的问题,马斯克公开直播时差点全球直播闯红灯应该就来自于此。

虽然马斯克云淡风轻说更多数据可以解决这个问题,但是这是一个端到端自动驾驶非常典型的bug。

曾经有幸与另一个端到端探索者公司Wayve的一位工程师交流时,对方也表示这是典型的问题,特斯拉端到端并未造假。(车机显示界面似乎是来自于类似于UniAD的模块初步解耦)

⚡与此同时,以前自动驾驶积累下来的测试手段几乎失效了,按照之前的工具链无法完成有效的测试。

例如为了降低成本加速开发的仿真测试,在分模块方案下,可以将规划控制单独出来测试,输入合适但是清楚的抽象条件。

类似于前方有一辆车插入本车道的描述可以直接交给规划控制,可以得出非常清楚的结果。

但是端到端方案需要提供相同场景下传感器级别的信号,例如一辆车cutin的视频流。

难度陡然提升,而且确定性也变弱。

目前看其实学术界和工业界都保持着怀疑的态度。

当然就像最初神经网络被广泛诟病的黑盒,因为Alexnet和 ImageNet测试集出现,在识别准确度上不输于人类,慢慢地识别这件事才能被交给神经网络。

而目前是否也将要存在一种端到端的方案,并且在某种数据集上面展现出足够的性能,整个方案黑盒的弊端才会被慢慢接受。

毕竟黑盒这件事,自动驾驶感知一直都有。