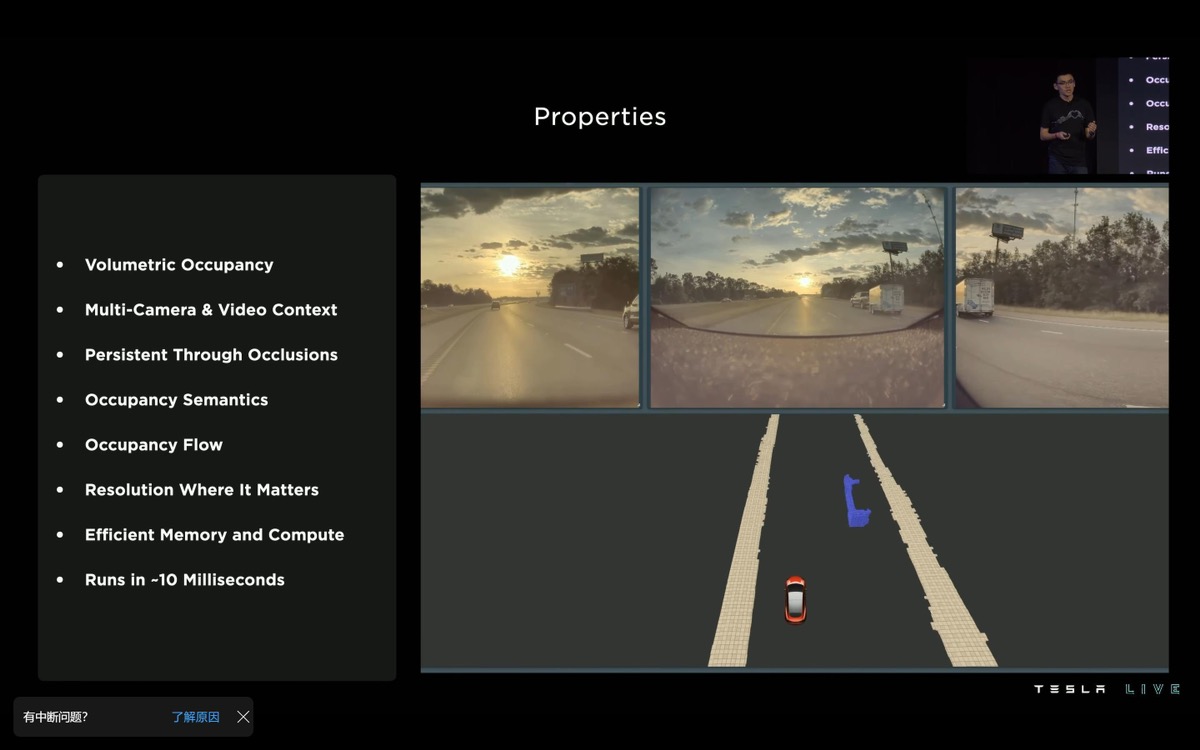

在特斯拉做出来 Occupancy Network 的占用网络之后,再聊一下我认为的摄像头和激光雷达(LiDAR)之争:

目前来看,特斯拉的占用网络迭代非常快,而且已经到了非常高的可用性。这也是为什么特斯拉今天敢出来说要进一步砍掉超声波传感器,核心就是把 FSD Beta 中的占用网络拿出来,下放到量产车上去取代超声波。

简单说下超声波,有超声波的车,大部分的本车剐蹭都是左右两边,要不是轮毂,要不是门,前后的剐蹭很少。因为超声波是前 6 后 6 各 180° 的半圆形覆盖,而左右两边轮毂、门上都没有超声波,前后靠的近了系统就会越来越刺耳的叫——这非常合理,左右两边都有后视镜啊——但有的人开车不看啊。

特斯拉说不用超声波,很多人认为 Elon Musk 疯了,等着大规模出事吧,理由是特斯拉没有做 360 的环视摄像头,离车最近的地方有盲区。

其实理论上来说,这个应该不是问题。因为特斯拉在 AI Day 上说得很明白,占用网络里是调用了汽车的里程计数据对接时序信息的。

也就是说,系统不是通过摄像头看到距离车 5 cm 的位置直接输出的,而是在距离车 100 cm 的位置开始计算,通过速度、时间推算出车再前进或后退多少,剩余距离是多少。

简单一句话:理论上,通过看得见的距离结合车辆的速度+时间是可以计算出看不见的距离的。

那么下一个问题是,超声波可以显示到厘米级,摄像头的精度够吗?

这个问题,我真的问过了太多人。前华为苏箐、极氪陈奇、小鹏吴新宙、理想李想,大家观点基本一致,摄像头测距的特点就是,距离越近越精确,随着距离越来越近,摄像头测距的精确性甚至可以超过激光雷达。

所以特斯拉不用超声波,用视觉做泊车辅助,我是谨慎偏乐观的。

那再说激光雷达,激光雷达的问题是什么,其实目前很多激光雷达的输出都是 10 Hz,这是一个 Bug。

我们看特斯拉在做城市的时候,转向了基于时序信息的 360° 视频流。这里特斯拉的摄像头是 36 Hz 的输出。因为你一旦做城市马上就会发现,那些突发的鬼探头、各种复杂路口的博弈时机都是转瞬即逝的。特斯拉传感器输入做得越来越快,本质上是在为后面的感知和规控处理争取时间。

这个时候激光雷达的 10 Hz 还要在传感器融合层和摄像头做时间同步,很扎心,越往后越难堪大用。

这么说好像激光雷达就完全没必要存在了一样?其实计算机视觉目前也还是有一个 Bug 的。摄像头测距,距离越近越精确,反过来,距离越远越模糊。

那这里就有一个 Corner Case 了:如果我是跑在高速上,怎么办?也就是我的需求就是必须在很远的距离外就能感知到非典型障碍物,怎么办呢?

Autopilot 不存在这个问题,因为驾驶员会看,FSD Beta 就必须要解决这个问题了。

当然,占用网络也还在不断的迭代,激光雷达也是一样。我甚至也不觉得特斯拉会死守 8 个摄像头的感知方案,特斯拉死守的大概是「解决自动驾驶的基本硬件配置」,不浪费但其实也不能有缺失。

如果摄像头有绝对无法解决的场景,HW 4.0 加什么传感器回来都不意外。