后 transformer 时代目前的研究方向有哪些?

先看一下近些年学术界关于 Transformer 的文献数量趋势[2]

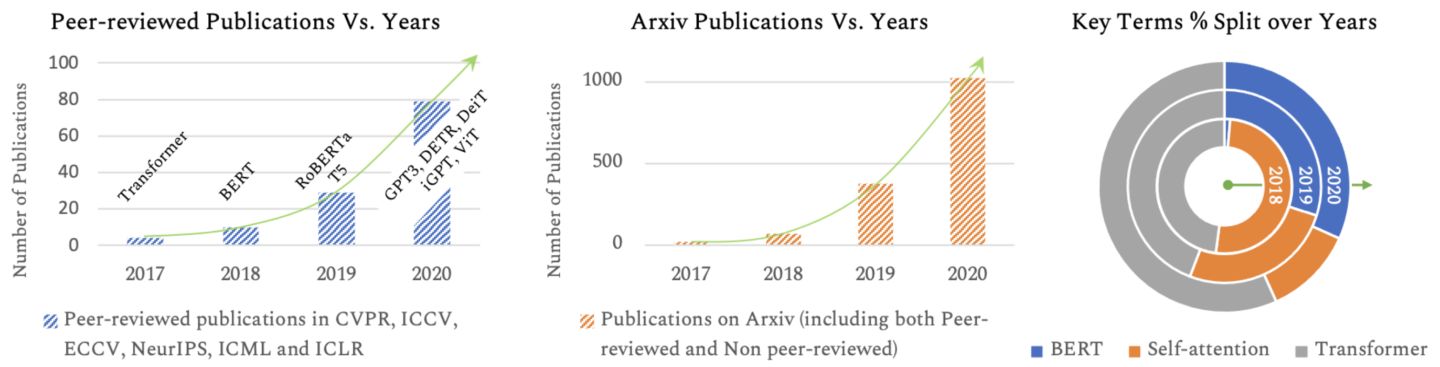

关于 Transofmer 的文献数量趋势

图表统计了在经过同行评审和 arXiv 的论文中,BERT, Self-Attention, and Transformers 这些关键词出现在标题中的数量。最后一个图是这三者的占比。可以发现关于 transformer 的研究目前正处在一个蓬勃发展的时期。

这里速读了两篇关于 Transformer 的综述[1,2], 下面列举部分 Transformer 的挑战和未来发展方向。

High Computational Cost

Transformer 模型的参数量一般比较大,在训练和推理时的计算成本较高,在 NLP领域中[3] 有了一些不错的探索,在CV中还需要更多探索。

High Data Cost

需要使用大量的训练数据进行预训练,而在某些领域, 例如多模态、医学等,数据量较小。如何实现高效利用数据仍然是一个开放的问题。

Need for Novel Designs

在CV中,大部分是直接使用 Transformer 的结构,需要一些更符合直觉的方式来更有效处理图像的输入。

Theoretical Analysis

Transformer 的体系结构已经被证明能够支持大规模训练数据。许多研究表明,Transformer比CNN和RNN具有更大的容量。但是,其理论原因尚不清楚,因此需要对 Transformer 的能力进行理论分析。

Unified Framework for Multimodal Data

目前 Transformer 在文本、图像、视频和音频方面取得了巨大的成功,有机会建立一个统一的框架,更好地捕捉多模态数据之间的内在联系。

参考

- A Survey of Transformers

- Transformers in Vision: A Survey - NASA/ADS

- Efficient Transformers: A Survey